Denna bloggpost handlar om forskningsframsteg inom matematiken, och då menar jag verkligen inom på ett sätt som exkluderar (det i och för sig ofantligt viktiga) tillämpandet av matematiska metoder i andra ämnen. En vanlig föreställning är att sådana inommatematiska framsteg utgörs av formulerandet och bevisandet av nya matematiska satser.1 Det ligger en hel del i denna föreställning, även om den är något grovhuggen, och idag vill jag lyfta fram en annan typ av framsteg som jag anser vara lika viktiga för matematikens framåtskridande, nämligen nya, enklare, kortare och helt enkelt bättre bevis av redan kända och bevisade satser.

Skälet till att den sortens framsteg är viktiga är följande. Matematik är en kumulativ verksamhet, där de framsteg som görs idag bygger på gårdagens, och kan på samma sätt väntas komma att ligga till grund för framtida framsteg. Nya satser och bevis bygger på gamla satser. Om nu dessa gamla satser har så komplicerade och svårtillgängliga bevis att inte dagens och morgondagens matematiker förmår smälta dem, så riskerar det intellektuella tankebygge som matematiken utgör att bli till en koloss på lerfötter där ingen längre begriper hur saker och ting egentligen hänger samman. Genom att lägga fram nya bevis som är enklare och mer lättilgängliga än originalbevisen (men naturligtvis fortsatt korrekta), så underlättar man för nya generationer matematiker att förstå den grund som de sedan hoppas kunna bygga vidare på.

Låt mig berätta om ett framsteg av detta slag som de båda unga franska matematikerna Hugo Duminil-Copin och Vincent Tassion nyligen gjort inom det område där jag själv på 90-talet fick mina främsta genombrott som matematiker: perkolationsteori. Detta område kan kort beskrivas som den gren av sannolikhetsteorin där man studerar modeller för genomsläpplighet i ostrukturerade material och konnektivitet i ostrukturerade nätverk. Det finns en uppsjö modeller inom perkolationsteorin, men en av de mest grundläggande är så kallad kantperkolation på Zd-gittret med dimension d=2 eller högre. Detta gitter har noder i heltalspunkterna i det d-dimensionella euklidiska rummet, och länkar mellan varje par av närmsta grann-noder (dvs noder på euklidiskt avstånd 1 från varandra); för d=2 bildas på så vis ett kvadratiskt gitter, för d=3 ett kubiskt, och för högre d ett hyperkubiskt. Så långt är alltsammans perfekt strukturerat, men den oordning som är typisk för perkolationsmodeller fås genom att länkar raderas slumpmässigt. Vi fixerar den så kallade perkolationsparametern p mellan 0 och 1, raderar varje länk oberoende av varje annan med sannolikhet 1-p, och behåller den således med sannolikhet p. (Detta fungerar på liknande vis som den perkolationsmodell på bikakegitter som jag diskuterade i en tidigare bloggpost.)

Ett centralt och inte särskilt svårt resultat, som går tillbaka till perkolationsteorins barndom på 1950-talet, är existensen av ett kritiskt värde pc sådant att existensen av en oändlig sammanhängande komponent i det därvid erhållna oordnade nätverket har sannolikhet 0 om p är i den så kallat subkritiska fasen p<pc, men 1 om p är i den superkritiska fasen p>pc. Det kritiska värdet för d=2 bevisades av Harry Kesten 1980 vara 1/2, medan exakta värden för pc i högre dimensioner ännu inte är kända.

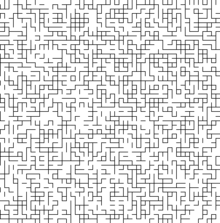

Följande bild av en realisering av denna perkolationsmodell med p=0,51 på Z2 är hämtad från Wikipedia.

Detta är bara ett lite stycke av realiseringen, då mönstret fortsätter oändligt långt i alla riktningar. Parametern p är vald strax över det kritiska värdet, vilket garanterar existensen av en oändlig sammanhängande komponent av noder och länkar.

Om vi istället hade valt ett subkritiskt p, så hade vi enbart fått ändliga komponenter. Det betyder att om vi startar i en given nod och bara får gå längs kvarvarande länkar, och om vi med βn betecknar sannolikheten att vi kan nå minst n längdenheter bort från ursprungsnoden, så går βn mot 0 då n går mot oändligheten. Ett av perkolationsteorins centrala framsteg på 1980-talet var att det, oavsett dimension d, gäller att så snart p<pc så går βn inte bara mot 0, utan gör det exponentiellt snabbt i n (med andra ord: det existerar positiva konstanter a och b sådana att βn<ae-bn oavsett n). För den matematiskt obevandrade kan detta resultat synas oskyldigt, men det understryker kraftfullt hur skarp övergången mellan subkritisk och superkritisk perkolation är. Resultatet bevisades av Mikhail Menshikov (1986) och av Michael Aizenman och David Barsky (1987), oberoende av varandra, på var sin sida av den dåvarande järnridån, och med två helt olika bevis. Båda bevisen är tämligen omfattande, och jag minns hur jag som ung och grön doktorand vintern 1991-1992 slet hårt med att smälta och förstå dem. Jag förstod dem till slut, men de är så invecklade att jag idag knappast skulle kunna rekonstruera dem utan att kika i facit.

In i handlingen träder nu de båda herrarna Duminil-Copin och Tassion, och deras aktuella uppsats A new proof of the sharpness of the phase transition for Bernoulli percolation on Zd, där de levererar ett kort och koncist bevis av det exponentiella avtagandet. Kort, koncist och enkelt - betydligt enklare än de båda ursprungliga bevisen av Menshikov respektive Aizenman och Barsky, vilka hittills varit standard. Det skall här medges att "enkelt" är ett relativt begrepp, och jag skulle inte rekommendera den läsare som inte redan är bevandrad i sannolikhetsteorin på åtminstone masternivå att ge sig i kast med att läsa uppsatsen, men för oss som är vana vid perkolationsteori är uppsatsen utmärkt lättsmält, och jag vågar mig nästan på att lova att om någon väcker mig mitt i natten om tio eller tjugo år och ber mig återge beviset så kommer jag att klara det.2 Jag tackar Hugo Duminil-Copin och Vincent Tassion för att de på detta vis gjort perkolationsteorin lite klarare för mig och för våra kollegor.

Fotnoter

1) Två av de mest spektakulära exemplen på sådana framsteg på denna sida millennieskiftet är Grigori Perelmans bevis av Poincarés förmodan, och Yitang Zhangs epokgörande delresultat på väg mot etablerandet av existensen av oändligt många primtalstvillingar.

2) Nyckeln till att komma ihåg beviset är att återkalla deras definition av storheten φp(S) i början av uppsatsen, och att det avgörande är huruvida denna storhet är mindre än 1. När väl det är på plats går räkningarna mer eller mindre av sig själva. (Detta visste givetvis inte Duminil-Copin och Tassion när de första gången försökte sig på sitt argument, men mycket av det som gör en skicklig matematiker är att kunna ana sig till i förväg vad som är en relevant kvantitet att börja räkna på i ett givet sammanhang.)

Skulle du placera in det nya respektive de två äldre bevisen i var sin grupp i karakteriseringen "evidenta vs uppenbara". Se Ulf Perssons text : http://www.math.chalmers.se/~ulfp/Didactics/did6.pdf

SvaraRaderaEller är det nya beviset fortfarande "bara evident" men på ett mer kompakt sätt än de gamla.

Jag drar mig för övrigt till minnes dina egna bevis av NFL-satserna som ju också gjorde dem till närmast triviala iaktagelser när man väl betraktade dem på rätt sätt.

Det är väldigt länge sedan jag läste den text av Ulf Persson som du länkar till, så jag har inte hans definitioner aktuella, men min skillnad i upplevelse av det nya kontra de äldre bevisen är så markant att jag gott kan tänka mig att det förtjänar betecknas som en elevering från "bara evident" till "uppenbar".

RaderaTrevligt med sådana resultat!

SvaraRaderaDu skriver "Parametern p är vald strax över det kritiska värdet, vilket garanterar existensen av en oändlig sammanhängande komponent av noder och länkar." Menar du verkligen det, eller skall det in ett "med sannolikhet 1"? Samma fråga då du talar om subkritiskt p lite i stycket efteråt.

Jag menar mycket riktigt "med sannolikhet 1", men ville inte utsätta läsekretsen för den sortens finlir som jag tror går över huvudet på flertalet.

RaderaJag tror att du underskattar (flertalet av) dina läsare.

RaderaMen, jag har också känslan att den kritiska nivån (fniss?) redan var nådd för de mindre matematiskt bevandrade, och att tilläggandet av "med sannolikhet 1" för korrekthets skull varken hade gjort till eller från för dem.

Nåväl, jag vill verkligen inte klaga. Jag tyckte att ditt inlägg var intressant, och det friskade upp gamla trevliga minnen från en kurs Jeff gav.

Vad jag dock blir lite nyfiken på, och som du jättegärna skulle få utvidga i ett framtida inlägg är vad som gör d=2 enklare än d>2? Eller kanske, vad det är som ställer till det i de högre dimensionerna, och speciellt: varför känner vi inte den kritiska nivån för d=3?

Viktigaste skillnaden är tillgång till planär dualitet.

RaderaIcke-matematiker skulle väl himla med ögonen för synonymen"nästan säkert".

RaderaSom det står i Lighthills bok om Fouriereserier och generaliserade funktioner :"To Paul Dirac, who saw that it must be true, To Laurent Schwartz who proved it. And to George Temple who showed how simple it all could be"

SvaraRaderaJag ser fram emot ett enkelt bevis för Fermats stora sats. Nu är vi alla beroende av AI, beträffande detta.

SvaraRaderaArtikeln väckte mitt intresse och en hågkomst från Uppsala universitet, och grundkurserna i analys. Med risk att etablerade matematiker ler lite, så ursäktar jag mig själv lite med att det var ca 36 år sedan jag tenterade av kursen. Men då, för 36 år sedan, skulle vi lära oss vad en kontinuerlig funktion var, och hur det definierades.

SvaraRaderaDet fanns en tämligen "enkel" metod som gick ut på att gränsvärdet skulle vara lika med funktionsvärdet i den aktuella punkten för att funktionen skulle vara kontinuerlig i punkten. Åtminstone var metoden lätt att förstå rent konceptuellt. Sedan fanns det en "delta" och "epsilon" metod. Och läraren vi hade, Lars Fjellstedt (Inom parentes sagt: Om någon som läser detta vet något om hans fortsatta karriär så ge gärna någon glimt), var noga med att vi just skulle använda "delta" och "epsilon" metoden. För det första minns jag att jag tyckte metoden var abstrakt; ingen förklarade vad man egentligen skulle mena med delta och epsilon. För det andra minns jag att det blev lite av mekaniskt inlärande, och på något sätt fixade jag till en korrekt lösning på tentan utan att egentligen förstå varför.

Till en yngre vän, som nyligen avslutat sin teknisk fysikutbildning, berättade jag om detta. Han log igenkännande och sa att i Umeå (och inte bara där), där han läste, är detta med delta och epsilon en "ökänd" definition bland teknologer.

Så visst är enklare framställningar ibland att föredra, och de verkar ha funnits tidigare också. Hur länge har t.ex. pi definierats som förhållandet mellan en cirkels omkrets och dess diameter....?

Kjell Eriksson

Det här är inte mycket till upplysning kanske, men jag hade också Lars Fjellstedt som föreläsare i Uppsala lite senare (för 21 år sedan, dvs 1994) och tyckte att han var bra. Dock har jag ungefär samma minnesbild som du av delta och epsilon :)

RaderaHej, long time no sea maybe, men jag träffade Lars Fjellstedt i tjänsten för två veckor sedan. Han lever ett aktivt liv tillsammans med frun Dorothy Irving och skulle säkert bli överlycklig att höra något ifrån sina gamla elever. Kontaktuppgifter finns närmast på hitta.se. Mvh Ylva Hållander

RaderaSamma notis till dig: Lars Fjellstedt lever i högönsklig förmåga (mötte honom i tjänsten för ett par veckor sen) och skulle säkert uppskatta några rader från en tidigare elev. (finns på hitta.se) :-)

RaderaKommer inte ihåg om jag svarat på detta, eller om jag inte lyckades få till det rent tekniskt. Men tack Ylva. Och upptäckte ditt svar först efter 3 år. Intressant med denna info. Dorothy Irving kände jag till sen tidigare( kanske pga mitt stora intresse för klassisk musik), men anade aldrig denna koppling.

SvaraRaderaKjell Eriksson