En medborgare och matematiker ger synpunkter på samhällsfrågor, litteratur och vetenskap.

måndag 17 december 2018

Kort om vetenskap och vetenskapssyn i Humanisten

torsdag 13 december 2018

Nu reder vi ut det här med Nordhaus och diskonteringsräntan

- Nordhaus, liksom många andra ekonomer, väljer att räkna ned värdet av kostnader som drabbar framtiden med en relativt hög nedräkningstakt (så kallad diskonteringstakt). Eftersom vi förväntas bli rikare i framtiden blir också kostnaderna för skadan relativt sett lägre. Men – och det här är mer kontroversiellt – Nordhaus (och många andra ekonomer) räknar också ned värdet av framtida skador enbart för att de uppstår i framtiden (den rena tidspreferensen).

Det här får oerhört stor betydelse. Med en diskonteringstakt på 5 procent per år blir en skada om 100 år hela 150 gånger mindre värd än om den inträffat i dag. Om 200 år betyder skadan i princip ingenting (22 000 gånger mindre). Eftersom klimatförändringarna är ett långsiktigt problem kan det därmed närmast trollas bort genom en teknikalitet.

- En modell med detta syfte måste i acceptabel grad överensstämma med vad vi faktiskt observerar. Detta tror jag är självklart för alla vad gäller de naturvetenskapliga delarna. Vi kan inte välja de parametrar som styr klimatkänsligheten utifrån vad vi vill att de skulle vara. De måste väljas så att modellens prediktioner är i linje med vad vi observerar. Det borde vara lika självklart att den ekonomiska modellen ska konstrueras så att den är i linje med vad vi observerar.

tisdag 4 december 2018

On the editorial board of the Journal of Controversial Ideas

torsdag 29 november 2018

Frukost med Formas

söndag 25 november 2018

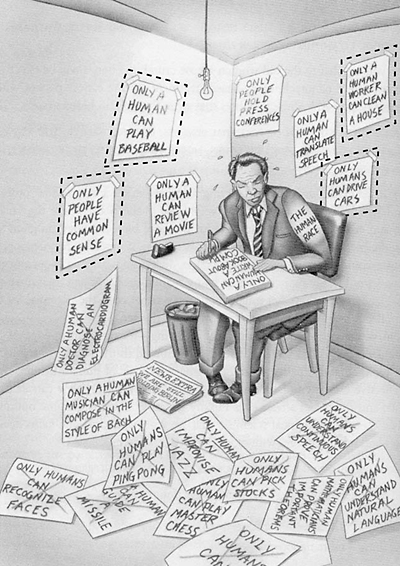

Johan Norberg is dead wrong about AI risk

- even if we invented super machines, why would they want to take over the world? It just so happens that intelligence in one species, homo sapiens, is the result of natural selection, which is a competitive process involving rivalry and domination. But a system that is designed to be intelligent wouldn't have any kind of motivation like that.

fredag 23 november 2018

Videofilmad i lärdomsstaden

måndag 19 november 2018

Förhandssnack inför AI-debatten i Lund på torsdag

- Med en av mina medpanelister på torsdag, datalogen Thore Husfeldt, har jag de senaste åren haft långa och givande diskussioner om AI-framtid, och trots att vi i vissa centrala frågor förbivit djupt oeniga har vi nu samlat oss till en gemensam artikel i dagens Sydsvenska Dagbladet med rubriken Om frihet är målet behövs en plan för hur ett samhälle utan arbete ska organiseras.1

- Med anledning av paneldebatten kontaktades jag i slutet av förra veckan av Sveriges främsta schacknyhetssajt Inte bara schack och av Sveriges näst främsta schacknyhetssajt schack.se,2 något som resulterade i bloggposter på båda ställena, rubricerade Paneldiskussioner i Lund och Stockholm respektive Efter Alpha Zero – ska vi vara rädda för AI.3

3) Vad gäller den sistnämnda vill jag en gnutta skamset framhålla att den inte är den bästa intervju jag givit. Jag svarade på frågorna via epost och hade ont om tid, och antog lite förhastat att det skulle komma följdfrågor. Jag borde åtminstone ha utvecklat att par av de mer korthuggna svaren. "Den potential AI har att berika samhällsekonomin och våra liv är enorm, men det gäller även riskerna" hade helt klart varit ett bättre och mer balanserat svar än "Riskerna är enorma" på frågan om huruvida vi bör vara rädda för AI.4 Och vad gäller jämförelsen mellan ett schackprogram och en robotiserad kassörska kunde jag exempelvis ha farmhållit att medan schackprogrammet har en välavgränsad spelplan, väldefinierade regler och en klockrent specificerad målfunktion så är allt detta ofantligt mycket mer komplicerat och oklart för en snabbköpskassörska, som behöver vara kapabel att hantera inte bara standardsituationer som att kvittorullen tar slut eller att kundens kreditkort visar sig ogiltigt, utan även en miljard andra situationer, som 6-åringen som gråter över att ha tappat bort sin förälder någonstans i den stora affären, pensionären som insisterar på att det stått i tidningen att grönkålen kostar 19:90, och fyllot som vomerar på varubandet eller som ställd inför upplysningen att endast personaltoalett finns svarar med att hota att urinera i lösgodiset.

4) Strängt taget tillför väl inte det längre svaret någon information som läsaren inte kan väntas redan känna till, men det handlar här mer om social signalering än om informationsöverföring i snäv mening. Det är viktigt för mig att framstå som en klok och balanserad tänkare snarare än som en extremist och en domedagspredikant.

onsdag 14 november 2018

Paneldiskussioner i Lund och Stockholm

- Hur smart är konstgjord intelligens? Debatt i Lund, AF-borgen, Lund, torsdagen den 22 november kl 20.00.

- Formas frukost: Forskning - på gott och ont? Nobelmuseet, Stockholm, torsdagen den 29 november kl 08.00.

tisdag 6 november 2018

Om effektiv altruism i P4

onsdag 31 oktober 2018

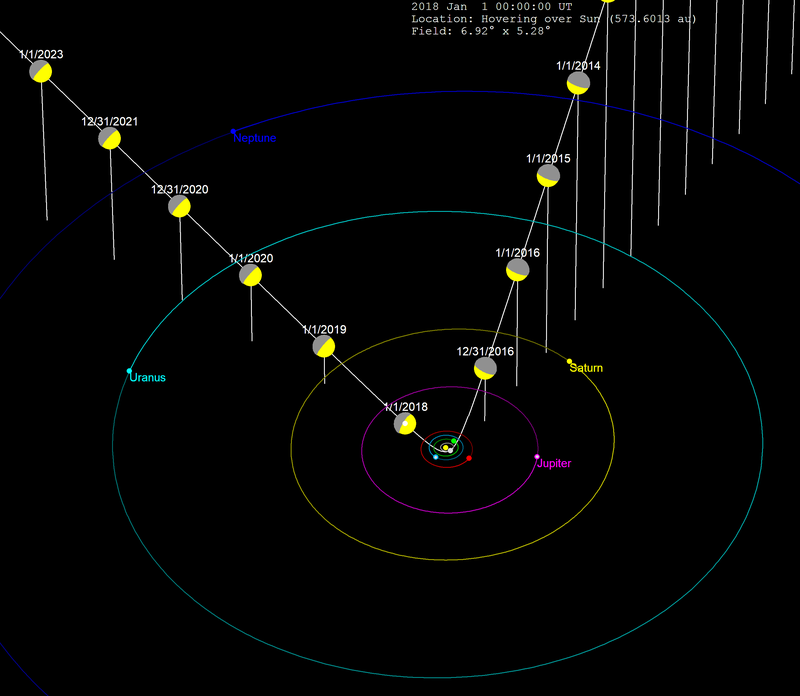

'Oumuamua-mysteriet

- Den är ovanligt avlång. Dess dimensioner är behäftade med osäkerhet, men den bästa uppskattningen pekar på en längd på 230 meter och bredd resepektive tjocklek på 35 meter vardera. Även om den ovanliga formen kan få den fantasifulle att associera till Clarkeska monoliter, så är det inte i sig tillräckligt för att vi på allvar skall börja fundera på om 'Oumuamua är ett artificiellt föremål från en utomjordisk civilisation, men det kommer mer:

- Robin Hanson (mannen bakom The Great Filter) påpekade samma höst att av interstellära objekt av 'Oumuamuas storlek som når tillräckligt långt in i vårt solsystem för att vi skall väntas observera dem, så träffar 'Oumuamua närmare Solen än 99% kan väntas göra, förutsatt att det inte suttit någon därute och avsiktligt siktat nära Solen. Källhänvisningen för denna sifferuppgift är inte klockren, men om vi ändå antar att den är riktig så har vi alltså ett p-värde på 0.01. Jag har i andra sammanhang framhållit att p-värden i den storleksordningen inte är fullt så imponerande som många tycks tro, och det gäller givetvis i än högre grad då nollhypotesen som i detta fall formulerats efter att man sett data. När alternativhypotesen är av så spektakulär natur som i detta fall - att någon avsiktligt skickat 'Oumuamua till vårt solsystem - är anledningen till skepsis ännu större, men jag kan inte se att det skulle vara något allvarligt fel att låta siffran inspirera oss att fundera vidare över den hypotesen. Och det kommer ännu mer:

- I en artikel i Nature tidigare i år påvisades att 'Oumuamua bana uppvisat avvikelser (med överväldigande statistisk signifikans) från vad gravitationsteorin förutsäger. En naturlig förklaring till en sådan avvikelse vore om 'Oumuamua likt en komet uppvisade avdunstning från ytan till följd av den infallande solstrålningen. Ett rykande (no pun intended) aktuellt preprint av astrofysikerna Shmuel Bialy och Abraham Loeb, och en kommentar till denna av Paul Gilster, hävdar dock att kometteorin inte håller. Istället föreslås solvind som en förklaring, vilket dock kräver att 'Oumuamua har så liten massa att den blott kan vara ett lövtunt skal (högst cirka 0.3 mm). Vad som kan skapa ett sådant objekt vet vi inte, men Bialy och Loeb föreslår att "one possibility is a lightsail floating in interstellar space as debris from an advanced technological equipment".

fredag 26 oktober 2018

Paul Christiano has just climbed to the top of my to-read list

onsdag 17 oktober 2018

I P4 igen, om statistik och våra felkalibrerade hjärnor

fredag 5 oktober 2018

Litet snack i P4 om sociala medier, chatbots och AI

måndag 1 oktober 2018

My paper on the Omohundro—Bostrom framework for AI goals and motivations

- The present

paper is concerned with scenarios where AI development

has succeeded in creating a machine that is superintelligent, in the sense of vastly outperforming humans across the full range of cognitive skills that we associate with intelligence, including

prediction, planning and the elusive quality we speak of as creativity. [...]

While important, [...] matters of timing and suddenness of AI development will mostly be abstracted away in the present paper, in order to focus on issues about what happens next, once a superintelligent machine has been created. A widely accepted thesis in contemporary AI futurology is that we humans can then no longer expect to be in control of our own destiny, which will instead be up to the machine. [...]

This leads to the crucial issue of what the superintelligent machine will want – what will it be motivated to do? The question is extraordinarily difficult and any answer at present is bound to come with a high degree of uncertainty – to a large extent due to our limited understanding of how a superintelligent machine might function, but also because the answer may depend on what we choose to do during the development stage, up to the point when we lose control. [...]

So our inexperience with superintelligence puts us in a situation where any reasoning about such a machine’s goals and motivations need to be speculative to a large degree. Yet, we are not totally in the dark, and the discussion need not be totally speculative and ungrounded. The main (and pretty much only) theoretical framework available today for grounding our reasoning on this topic is what in an earlier publication I decided to call the Omohundro—Bostrom theory on instrumental vs final AI goals [...]. The two cornerstones of the theory are what Bostrom (2012) dubbed the Orthogonality Thesis (OT) and the Instrumental Convergence Thesis (ICT), which together give nontrivial and (at least seemingly) useful predictions – not about what will happen, but about what might plausibly happen under various circumstances. The OT and the ICT are, however, not precise and definite on the level that mathematical theorems can be: they are not written in stone, and they have elements of vagueness and tentativeness. The purpose of the present paper is to discuss some reasons to doubt the two theses – not with the intent of demonstrating that they are wrong or useless, but mostly to underline that further work is needed to evaluate their validity and range of applicability.

torsdag 27 september 2018

Blunda inte!

- AI-utvecklingen har potential inte bara att göra världen bättre, utan också att göra den sämre, och i värsta fall orsaka katastrof. Jag ser därför framför mig ett abstrakt landskap av möjliga framtida AI-framsteg, där det bland guld och gröna skogar även finns blindskär och livsfarliga minor (för att nu ohämmat blanda metaforer). Den anda av att vi snabbast möjligt bör göra så stora teknikframsteg som möjligt, vilken präglade såväl det Chalmersmöte jag här berättat om som den mesta annan AI-diskussion vi ser i dag, är liktydig med att blint rusa rakt fram i detta minfält, eller att köra bil med gasen i botten och ögonen enbart på hastighetsmätaren utan en tanke på vilka hinder och andra farligheter som kan finnas där ute.

Detta duger inte. Vi behöver ta några djupa andetag och fundera över vilken slags framtid vi vill att AI-utvecklingen ska bidra till, vilka riskerna är, och hur vi bör agera för att skörda de största frukterna där ute samtidigt som vi undviker de farligaste minorna.

tisdag 18 september 2018

An essential collection on AI safety and security

söndag 2 september 2018

Snyder on Putin and the threats to freedom and democracy

- [The Russian invasion of Crimea in 2014] violates basic consensual principles of international law, the United Nations Charter, every treaty signed between independent Ukraine and independent Russia, as well as a number of assurances that Russia has offered Ukraine about the protection of its frontiers. One of these was the Budapest Memorandum of 1994, in which the Russian Federation (along with the United Kingdom and the United States) had guaranteed Ukranian borders when Ukraine agreed to give up all nuclear weapons. In what was perhaps the greatest act of nuclear disarmament in history, Ukraine handed over some 1,300 intercontinental ballistic missiles. By invading a country that had engaged in complete nuclear disarmament, Russia offered the world the lesson that nuclear arms should be pursued. [p 142]

lördag 1 september 2018

Demokrati är fundamentalt - är alla med på det?

- Skulle Moderaternas partiledare Ulf Kristersson ställa sig bakom uttalandet "Sänkt skatt är förvisso viktigt. Ett ännu mer grundläggande ideal för oss är emellertid bevarandet av demokratin, och med det skulle vi aldrig kompromissa"? Det behöver vi inte undra över, svaret är tveklöst ja.

- Skulle Kristdemokraternas partiledare Ebba Busch Thor ställa sig bakom uttalandet "Hårdare straff för vålds- och sexbrott är förvisso viktigt. Ett ännu mer grundläggande ideal för oss är emellertid bevarandet av demokratin, och med det skulle vi aldrig kompromissa"? Tvivelsutan skulle hon det.

- Skulle Liberalernas partiledare Jan Björklund ställa sig bakom uttalandet "Höjda lärarlöner är förvisso viktigt. Ett ännu mer grundläggande ideal för oss är emellertid bevarandet av demokratin, och med det skulle vi aldrig kompromissa"? Självklart.

- Skulle Centerns partiledare Annie Lööf ställa sig bakom uttalandet "Levande landsbygd är förvisso viktigt. Ett ännu mer grundläggande ideal för oss är emellertid bevarandet av demokratin, och med det skulle vi aldrig kompromissa"? Det skulle hon såklart.

- Skulle Socialdemokraternas partiledare Stefan Löfven ställa sig bakom uttalandet "Schyssta villkor och löner i arbetslivet är förvisso viktigt. Ett ännu mer grundläggande ideal för oss är emellertid bevarandet av demokratin, och med det skulle vi aldrig kompromissa"? Det kan vi känna oss förvissade om.

- Skulle Miljöpartiets båda språkrör Gustav Fridolin och Isabella Lövin ställa sig bakom uttalandet "Omställning till förnyelsebara energikällor är förvisso viktigt. Ett ännu mer grundläggande ideal för oss är emellertid bevarandet av demokratin, och med det skulle vi aldrig kompromissa"? Självklart skulle båda två göra det.

- Skulle Vänsterpartiets partiledare Jonas Sjöstedt ställa sig bakom uttalandet "Sex timmars arbetsdag är förvisso viktigt. Ett ännu mer grundläggande ideal för oss är emellertid bevarandet av demokratin, och med det skulle vi aldrig kompromissa"? Givetvis.

- Skulle Sverigedemokraternas partiledare Jimmie Åkesson ställa sig bakom uttalandet "Stoppad invandring är förvisso viktigt. Ett ännu mer grundläggande ideal för oss är emellertid bevarandet av demokratin, och med det skulle vi aldrig kompromissa"? Nja, inför en sådan jämförelse mellan partiets hjärtefråga och bevarandet av demokratin skulle han antagligen börja slira. Svärmorsdrömmen Åkesson är vanligtvis skicklig på att låta mer städad och rumsren än mer brutala sd-företrädare som Kenth Ekeroth, Linus Bylund och Björn Söder, men häromdagen avslöjade han sin bristande demokratiska ryggrad genom att vägra välja mellan Emmanuel Macron och Vladimir Putin. Han och hans parti är helt enkelt inte att lita på när det gäller att stå upp för demokratin.

söndag 26 augusti 2018

Tom Lehrer om Wernher von Braun

fredag 24 augusti 2018

On the ethics of emerging technologies and future scientific advances

- My aim in this text is to explain and defend my viewpoint concerning the role of science in society and research ethics which permeates the ethical arguments in my recent book Here Be Dragons: Science, Technology and the Future of Humanity (Häggström, 2016). To clarify my view, I will contrast it with two more widespread points of view which I will call the academic-romantic and the economic-vulgar. These will be sketched in Section 2. In Section 3 I explain what is missing in these approaches, namely, the insight that scientific progress may not only make the world better but may also make it worse, whence we need to act with considerably more foresight than is customary today. As a concrete illustration, I will in Section 4 discuss what this might mean for a specific area of research, namely artificial intelligence. In the concluding Section 5 I return to some general considerations about what I think ought to be done.

torsdag 16 augusti 2018

Man får inte skicka folk i döden

- Sara kommer från ett land som är ett av de absolut farligaste i världen för kvinnor. Våldsbrott mot flickor och kvinnor för att uppehålla familjens heder ses i Afghanistan som en privatsak. Den som söker hjälp hos myndigheterna efter en våldtäkt riskerar att dödas. Att giftas bort mot sin vilja är vanligt.

Sara berättar att hon giftes bort som 15-åring till en 11 år äldre släkting. Morföräldrarna utsåg maken. Enligt Sara fick hon inte fortsätta studierna när giftermålet var bestämt, och maken skrämde henne när de träffades enskilt.

– Han talade illa om min familj, slog mig, rev sönder mina kläder. Det är jobbigt att berätta det här, säger hon och hennes ögon tåras.

[...]

Hon beskriver en strapatsrik resa. Det hon berättar sedan ekar i så många hedersutsatta flickors och pojkars erfarenheter. Trycket från släkten som hårdnar, som blir till ett krav, ett hot. Vittnesmål som vi måste lyssna på. Sara beskriver hur hennes pappa började pressa henne att återvända till maken.

– Tänk på min heder, sa min pappa, och jag mådde väldigt dåligt, säger Sara.

Enligt Sara utsattes hon även för hot från sin make och hans släktingar.

– “Om vi hittar dig så dödar vi dig. Om du inte säger var du är så tar vi din syster i stället”, sa de över telefon. Min syster var bara nio år då. Min mamma och syster lever fortfarande gömda i Iran.

[...]

Migrationsverket föreslår i sitt beslut att hennes make kunde möta upp henne vid flygplatsen. “Du har uppgett att du är gift och har en make som är bosatt i din hemby. Du har inte gjort sannolikt att han utgör en hotbild mot dig. Han utgör således ett manligt nätverk för dig.”

onsdag 15 augusti 2018

Singularities

-

(1) The name Häggström appears four times in the short paper, and in all four cases it is me that the name refers to. I am flattered by being considered worthy of such attention.

-

(2) The paper was published in the summer of 2017, a large fraction of it is devoted to countering arguments by me, and the author is a Chalmers University of Technology colleague of mine with whom I've previously had fruitful collaborations (resulting in several joint papers). These observations in combination make it slightly noteworthy that the paper comes to my attention only now (and mostly by accident), a full year after publication.

(3) The reference list contains 10 items, but strikingly omits the one text that almost the entire Section 2 of the paper attempts to engage with, namely my February 2017 blog post Vulgopopperianism. That was probably not by mistake, because at the first point in Section 2 in which it is mentioned, its URL address is provided. So why the omission? I cannot think of a reason other than that, perhaps due to some grudge against me, the author wishes to avoid giving me the bibliometric credit that mentioning it in the reference list would yield. (But then why mention my book Here Be Dragons in the reference list? Puzzling.)

(4) In my Vulgopopperianism blog post I discuss two complementary hypotheses (H1) and (H2) regarding whether superintelligence is achievable by the year 2100. Early in Section 2 of his paper, Dubhashi quotes me correctly as saying in my blog post that "it is not a priori obvious which of hypotheses (H1) and (H2) is more plausible than the other, and as far as burden of proof is concerned, I think the reasonable thing is to treat them symmetrically", but in the very next sentence he goes overboard by claiming that "Häggström suggests [...] that one can assign a prior belief of 50% to both [(H1) and (H2)]". I suggest no such thing in my blog post, and certainly do not advocate such a position (unless one reads the word "can" in Dubhashi's claim absurdly literally, meaning "it is possible for a Bayesian to set up a model in which each of the hypotheses has probability 50%"). If the sentence that he quoted from my blog post had contained the passage "as far as a priori probabilities are concerned" rather then "as far as burden of proof is concerned", then his claim would have been warranted. But the fact is that I talked about "burden of proof", not "a priori probabilities", and it is clear from this and from the surrounding context that what I was discussing was Popperian theory of science rather than Bayesianism.1 It is still possible that the mistake was done in good faith. Perhaps, despite being a highly qualified university professor, Dubhashi does not understand the distinction (and tension) between Popperian and Bayesian theory of science.2

2) If this last speculation is correct, then one can make a case that I am partly to blame. In Chapter 6 of Here Be Dragons - which Dubhashi had read and liked - I treated Popperianism vs Bayesianism at some length, but perhaps I didn't explain things sufficiently clearly.

torsdag 9 augusti 2018

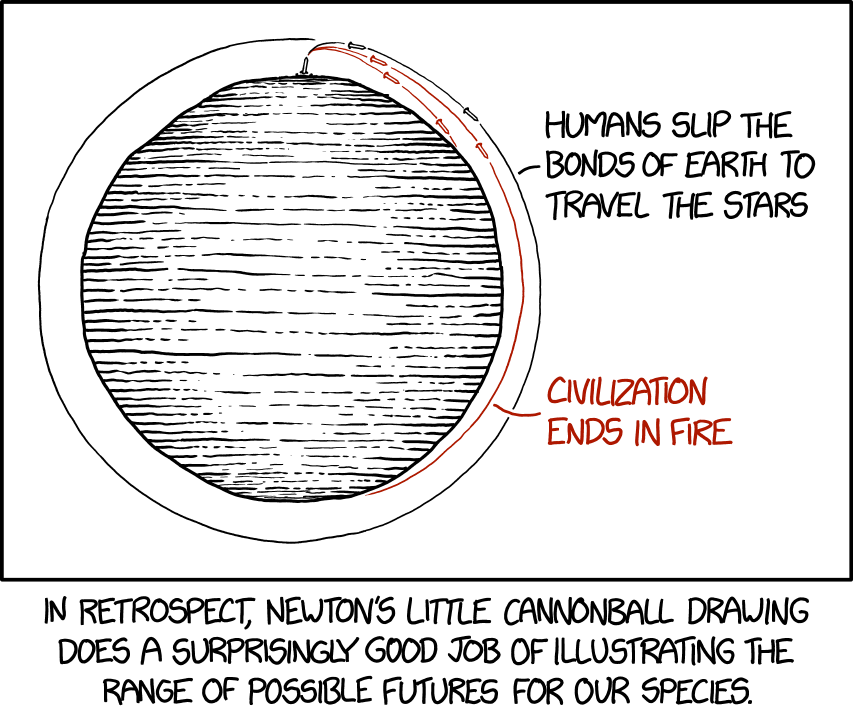

In the long run

- Society today needs greater attention to the long-term fate of human civilization. Important present-day decisions can affect what happens millions, billions, or trillions of years into the future. The long-term effects may be the most important factor for present-day decisions and must be taken into account. An international group of 14 scholars calls for the dedicated study of “long-term trajectories of human civilization” in order to understand long-term outcomes and inform decision-making. This new approach is presented in the academic journal Foresight, where the scholars have made an initial evaluation of potential long-term trajectories and their present-day societal importance.

“Human civilization could end up going in radically different directions, for better or for worse. What we do today could affect the outcome. It is vital that we understand possible long-term trajectories and set policy accordingly. The stakes are quite literally astronomical,” says lead author Dr. Seth Baum, Executive Director of the Global Catastrophic Risk Institute, a non-profit think tank in the US.

[...]

The scholars find that status quo trajectories are unlikely to persist over the long-term. Whether humanity succumbs to catastrophe or achieves a more positive trajectory depends on what people do today.

“In order to succeed it is important to have a plan. Long-term success of humanity depends on our ability to foresee problems and to plan accordingly,” says co-author Roman Yampolskiy, Associate Professor of Computer Engineering and Computer Science at University of Louisville. “Unfortunately, very little research looks at the long-term prospects for human civilization. In this work, we identify some likely challenges to long-term human flourishing and analyze their potential impact. This is an important step toward successfully navigating such challenges and ensuring a thriving future for humanity.”

The scholars emphasize the enormous scales of the long-term future. Depending on one’s ethical perspective, the long-term trajectories of human civilization can be a crucial factor in present-day decision-making.

“The future is potentially exceedingly vast and long,” says co-author Anders Sandberg, Senior Research Fellow at the Future of Humanity Institute at University of Oxford. “We are in a sense at the dawn of history, which is a surprisingly powerful position. Our choices – or lack of decisions – will strongly shape which trajectory humanity will follow. Understanding what possible trajectories there are and what value they hold is the first step towards formulating strategies for our species.”

tisdag 31 juli 2018

On dual-use technologies

onsdag 27 juni 2018

Thinking in advance, in Uppsala

fredag 15 juni 2018

Livet med AI

torsdag 7 juni 2018

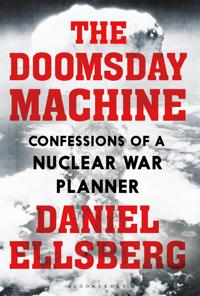

Kärnvapenfrågan är på dödligt allvar

- Risken för globalt kärnvapenkrig [är] något vi haft hängande över oss ända sedan tidigt 1950-tal. I samband med Berlinmurens fall och Sovjetunionens upplösning åren kring 1990 försvann kärnvapenfrågan i hög grad från det allmänna medvetandet, vilket var en kollektiv missbedömning av stora mått. Även om det globala antalet kärnvapenstridsspetsar minskat till mindre än en tredjedel av vad det var som mest, försvann aldrig hotet om en kärnvapenapokalyps. Medvetenheten om problemet har i någon mån återvänt i samband med att en man med en tioårings impulskontroll, stingslighet och allmänna mognad i januari 2017 utsågs till högste befälhavare för världens mäktigaste militärmakt, men är ändå inte tillbaka på den nivå som gällde under delar av det kalla kriget.

Den amerikanske före detta krigsanalytikern Daniel Ellsberg vill med sin aktuella bok The Doomsday Machine: Confessions of a Nuclear War Planner (Bloomsbury Press, 2017) väcka oss ur denna slummer och få oss att inse farans omfattning. Kärnvapenhotet är inget mindre än ett existentiellt hot, det vill säga ett hot som om det vill sig illa kan bli slutet för mänskligheten. Visserligen finns inte tillräckligt många kärnvapen för att döda hela jordens befolkning i själva kriget, men följdverkningarna, inklusive den atomvinter som väntas förmörka himlen och slå ut allt jordbruk under flera år, riskerar att bli så stora att det är ytterst osäkert om de återstående civilisationsspillrorna skulle klara sig särskilt länge.

Ellsberg är en intressant och på många vis beundransvärd person. Han föddes 1931, han doktorerade vid Harvard på en briljant avhandling om beslutsteori, och han arbetade under 1960-talet som militärstrategisk konsult vid det amerikanska försvarsdepartementet. Denna karriär fick emellertid ett abrupt slut då han 1971 läckte de så kallade Pentagon Papers, en samling topphemliga dokument som delvis kom att publiceras i New York Times och Washington Post, och som klargjorde Johnsonadministrationens systematiska lögner (gentemot inte bara allmänheten utan också den amerikanska kongressen) om Vietnamkriget. Ellsberg erkände öppet att det var han som var läckan, något som normalt skulle ha renderat honom ett mångårigt fängelsestraff för spioneri, men en sinkadusartad omständighet med förgreningar i Watergateskandalen gjorde att domaren i maj 1973 såg sig nödsakad att lägga ned åtalet mot honom. Sedan dess har Ellsberg verkat som opinionsbildare och politisk aktivist, och The Doomsday Machine kan ses som kulmen på detta arbete.

Boken präglas av skarpsinne och en brinnande moralisk låga, och har sitt allra största värde i författarens unika erfarenheter från åren som militärstrategisk insider. Det man som läsare framför allt får med sig är vilken grad av tur vi har haft som så här långt överlevt hotet om globalt kärnvapenkrig.

tisdag 29 maj 2018

Om friskolor och betyg

- I Sverige tycker vi att en elevs lärare är den som bäst bedömer elevens kunskaper och därför låter vi lärare sätta betyg på sina elever. Det är ett betygssystem som bygger på tillit.

Vi har dock också ett utpräglat marknadssystem för skolan. Höga betyg är en konkurrensfördel, så det skapar incitament för skolor alla att sätta högre betyg än vad elevernas kunskapsnivåer förtjänar. I klarspråk kan man säga att skolor drivs att fuska med betygen för att skaffa sig bättre positioner på marknaden.

Om alla skolor gjorde detta lika mycket skulle det ändå vara dåligt, för det leder till betygsinflation. Men det skulle vara ett slags rättvist fusk. Så är det dock inte. Friskolor fuskar mer. Och de stora vinstdrivande koncernernas skolor fuskar mycket mer. Jättemycket faktiskt, och värst är Kunskapsskolan och Internationella Engelska skolan.

Det här visar Jonas Vlachos i en ny rapport. Han använder inte termen fusk, men jag tycker att det är en rimlig term.

Man ser ibland argument för att friskolorna är bra, för att de har bättre kunskapsresultat. Men Jonas visar att HELA betygsövertaget som t ex Kunskapsskolan har över kommunala skolan kan förklaras av Kunskapsskolans tendens att sätta högre betyg (relativt de resultat som elever visat på prov) än den kommunala skolan.

Det här är ju inte bara orättvist. Det underminerar på flera sätt förtroendet för både skolsystemet och betygssystemet. Det kommer också tvinga oss att överge ett system där vi litar på att lärare som bedömare av elevers kunskap. Dessutom har hela det här fusket i sig skapat möjlighet att propagera för förträffligheten hos de vinstdrivande skolorna på falska grunder.

Internationella Engelska skolan och Kunskapsskolan, som är de värsta här, borde skämmas. Men det borde även de politiker som var naiva nog att införa det här systemet.

torsdag 17 maj 2018

An open letter to Google

Concerned world citizen

måndag 14 maj 2018

Two well-known arguments why an AI breakthrough is not imminent

torsdag 3 maj 2018

Rekommenderad läsning: Aaronson om Caplan om utbildning