Med superintelligens menar Nick Bostrom, i sin bok Superintelligence: Paths, Dangers, Strategies från 2014, på ett ungefär en intelligens som vida överskrider den mänskliga i alla väsentliga avseenden. Han menar att det är troligt att vi så småningom lyckas skapa en superintelligent maskin, och att det långt ifrån kan uteslutas att detta händer inom något eller några få decennier. Jag instämmer i min nya bok Here Be Dragons: Science, Technology and the Future of Humanity. Både Bostrom och jag ägnar stort utrymme i våra respektive böcker åt Eliezer Yudkowskys begrepp Friendly AI, vilket går ut på att den allra första superintelligenta maskinen i förväg behöver ha försetts med värderingar och mål som leder fram till att den i senare skeden prioriterar mänsklig välfärd, ty i annat fall kan det gå riktigt illa för oss människor. I sin inflytelserika och läsvärda uppsats Artificial Intelligence as a Positive and Negative Factor in Global Risk från 2008 skisserar Yudkowsky vikten av och svårigheterna i att lyckas med Friendly AI. Han nämner också en primitiv föregångare i form av Asimovs tre robotlagar, vilka i den på Wikipedia redovisade svenska översättningen lyder som följer:

- 1. En robot får aldrig skada en människa eller, genom att inte ingripa, tillåta att en människa kommer till skada.

2. En robot måste lyda order från en människa, förutom om sådana order kommer i konflikt med första lagen.

3. En robot måste skydda sin egen existens, såvida detta inte kommer i konflikt med första eller andra lagen.

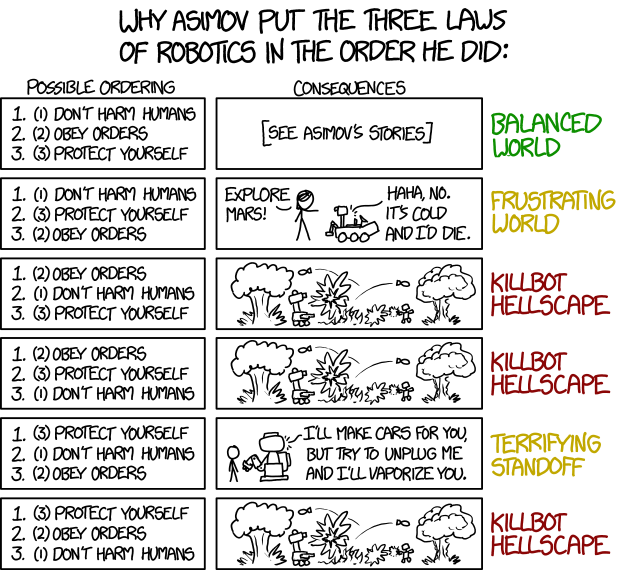

Webbserien xkcd tog i förra månaden upp frågan om vad som händer om man kastar om prioritetsordningen mellan de tre lagarna:

Som en första rudimentär övning i att analysera konsekvenserna av en given formaliserad robotetik tycker jag detta är utmärkt. Dock undrar jag om inte en minst lika trolig konsekvens av den femte permutationen är ännu ett fall av killbot hellscape, om maskinerna kommer fram till att människorna, i deras allmänna nyckfullhet, utgör en säkerhetsrisk gentemot maskinerna, och därför bedömer att det är nödvändigt att i förebyggande syfte avskaffa mänskligheten.

Inga kommentarer:

Skicka en kommentar